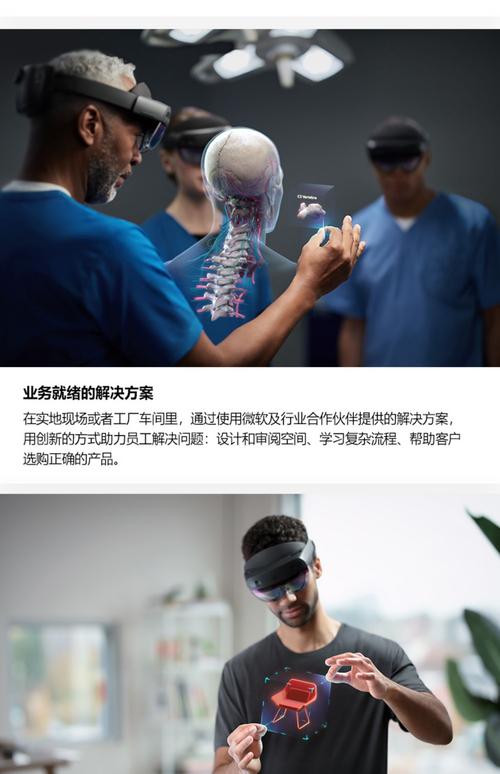

Hololens的技术融合了光学显示、空间计算、环境感知、人机交互等多个前沿领域,其核心在于通过硬件与软件的协同,将数字信息叠加到真实世界中,实现虚实结合的沉浸式体验,从技术架构来看,Hololens可分解为光学显示系统、传感器阵列、计算平台、交互模块及软件生态五个关键部分,每一部分都体现了高度的技术集成与创新。

光学显示系统是Hololens实现“混合现实”视觉呈现的基础,与传统VR设备将屏幕置于眼前不同,Hololens采用“光波导”(Lightwaveguide)技术,通过特殊镀膜的玻璃片将数字图像以全息形式投射到用户视网膜上,这一技术包含两个核心组件:光引擎和衍射光栅,光引擎中的微型显示屏生成图像后,通过衍射光栅将光线多次反射并扩散,最终以52度视场角(FOV)呈现在用户视野中,同时保持现实环境的通透性,为确保图像清晰度,Hololens 2采用了双4K微显示屏,分辨率提升至单眼1920x1080像素,并支持自动亮度调节以适应不同光照环境,其光学系统还配备了“深度传感器校准”功能,通过实时调整光路畸变,确保虚拟物体与真实场景的透视一致性,避免用户产生视觉疲劳。

传感器阵列是Hololens感知环境与用户状态的核心,其集成了多种传感器以实现空间定位与环境理解。“惯性测量单元”(IMU)包含加速度计、陀螺仪和磁力计,用于追踪头部运动,刷新率达1000Hz,确保虚拟物体随头部移动的实时响应,深度传感器采用飞行时间(ToF)技术,通过红外激光发射器与传感器模组,可实时绘制周围环境的3D点云模型,精度达厘米级,范围从0.5米到5米,Hololens还配备四个“环境理解摄像头”(Environmental Understanding Cameras),通过计算机视觉算法识别平面、边缘及空间结构,支持虚拟物体在真实表面的稳定放置,当用户将虚拟桌“放置”在真实地面时,系统会通过SLAM(同步定位与地图构建)技术持续追踪平面位置,避免物体因移动而漂移,眼球追踪摄像头通过红外光源捕捉用户瞳孔位置,实现“凝视选择”交互,而内置的麦克风阵列则支持语音指令的远场拾取与降噪处理。

计算平台负责处理传感器数据并渲染混合现实内容,Hololens采用了定制化的异构计算架构,其搭载的HPU(全息处理单元)是核心亮点,这是一款专为混合现实设计的AI加速芯片,最初版本包含28个核心,可执行每秒1万亿次运算(TOPS),用于实时处理SLAM算法、手势识别及空间映射,HPU的并行计算能力大幅降低了CPU与GPU的负载,使得Hololens在低功耗状态下仍能流畅运行复杂应用,硬件层面,Hololens 2搭载高通骁龙XR1平台,采用8核64位CPU,Adreno 640 GPU支持DirectX 12与OpenXR图形标准,确保与现有3D引擎的兼容性,存储方面,配备64GB/128GB UFS闪存,支持Wi-Fi 6无线连接,可实现云端数据同步与多设备协同,为优化散热,Hololens采用“液冷散热管”技术,将芯片热量传导至机身框架,避免长时间使用因过热导致的性能下降。

交互模块是用户与混合现实世界沟通的桥梁,Hololens支持多种自然交互方式,手势识别通过“手势追踪摄像头”实现,该摄像头以红外模式捕捉用户手部骨骼节点,支持捏合、点击、挥手等11种手势,识别延迟低于30ms,Hololens 2进一步引入“压力感应”,通过检测手指弯曲角度区分“轻触”与“抓握”动作,提升交互精度,语音交互基于Azure认知服务,支持自然语言理解与多语言识别,用户可通过语音指令控制界面或触发应用,放置一个立方体”或“打开浏览器”,对于企业级应用,Hololens还支持“物理控制器接入”,通过蓝牙连接外部手柄或专业设备,实现精细操作,其“空间音频”技术通过耳机模拟声音在真实环境中的反射与衰减,使用户能通过声音方向判断虚拟物体的位置,增强沉浸感。

软件生态是Hololens技术落地的关键支撑,其基于Windows Mixed Reality平台,提供完整的开发工具链,开发者可通过Unity、Unreal Engine等引擎构建应用,并利用Microsoft提供的Mixed Reality Toolkit(MRTK)快速集成手势识别、空间锚点等功能,Azure Spatial Anchors服务允许用户在不同设备间共享虚拟物体的空间位置,实现跨设备协同,在安全与隐私方面,Hololens采用“硬件级加密”技术,所有传感器数据本地处理,仅必要信息上传云端,并通过Windows Hello实现面部识别登录,企业版还支持Active Directory域管理,满足大型组织的IT合规需求。

| 技术模块 | 核心组件 | 功能特点 |

|---|---|---|

| 光学显示系统 | 光波导、衍射光栅、双4K显示屏 | 视场角52度,支持自动亮度调节,透视一致性校准 |

| 传感器阵列 | ToF深度传感器、SLAM摄像头、IMU | 3D点云建模,厘米级定位,头部运动追踪刷新率1000Hz |

| 计算平台 | HPU芯片、骁龙XR1、Adreno 640 GPU | 异构计算架构,每秒1万亿次运算,支持DirectX 12与OpenXR |

| 交互模块 | 手势追踪、语音识别、空间音频 | 11种手势识别,延迟30ms,物理反射模拟 |

| 软件生态 | MRTK工具包、Azure Spatial Anchors | 跨引擎开发支持,空间锚点共享,企业级安全加密 |

相关问答FAQs:

-

问:Hololens的光学显示技术如何解决长时间使用的视觉疲劳问题?

答:Hololens采用“光波导”技术将虚拟图像以全息形式投射到视网膜,避免传统VR屏幕的聚焦差异;同时支持自动亮度调节与深度传感器校准,确保虚拟物体与真实环境的透视一致性,减少眼睛调节压力,其开放式设计允许用户随时观察真实环境,降低封闭式头显带来的眩晕感。 -

问:Hololens的SLAM技术在复杂环境中如何保持空间定位的稳定性?

答:Hololens通过多传感器融合提升SLAM稳定性:ToF传感器提供深度数据,环境理解摄像头捕捉平面特征,IMU追踪头部运动,三者数据实时融合构建空间地图,当遇到弱纹理环境时,系统会激活“惯性导航模式”,基于IMU数据预测位置变化,并结合Wi-Fi信号与地磁校准,确保定位误差控制在5厘米以内。 (图片来源网络,侵删)

(图片来源网络,侵删)