alphago的技术亮点主要体现在其深度强化学习框架、蒙特卡洛树搜索算法的创新应用、以及强大的策略网络和价值网络的协同工作等方面,其核心技术突破在于将深度学习与蒙特卡洛树搜索(MCTS)深度融合,通过自我对弈和策略迭代实现了围棋领域的跨越式突破。

alphago的核心架构由三个关键神经网络组成:策略网络(Policy Network)、价值网络(Value Network)和蒙特卡洛树搜索(MCTS),策略网络负责从当前棋盘状态预测下一步的落子概率,该网络通过监督学习的方式,学习人类职业棋手的对弈数据,初始版本(alphago Fan)的策略网络准确率达到57%,相当于业余高段棋手的水平,而alphago Zero版本的策略网络则完全通过自我对弈生成数据,摆脱了对人类数据的依赖,实现了更高效的策略优化,价值网络则用于评估当前棋盘状态的胜率,通过输出一个0到1之间的概率值,判断当前局势对哪一方更有利,这一网络同样通过自我对弈数据进行训练,其评估能力远超传统的启发式函数,能够更精准地判断复杂局势。

在搜索算法方面,alphago对传统的蒙特卡洛树搜索进行了革命性改进,传统MCTS依赖于随机模拟(rollout)来评估局面,计算效率低且评估精度有限,alphago则用策略网络和价值网络替代了随机模拟:在树搜索的扩展阶段,策略网络指导搜索方向,优先探索概率较高的落子点,大幅减少了无效搜索;在评估阶段,价值网络直接输出局面胜率,避免了大量随机模拟带来的不确定性,这种“ guided MCTS”方法将搜索效率提升了数个数量级,使得alphago能够在有限时间内进行更深入的局势分析,在 alphago Lee与李世石的对局中,每步棋的搜索深度可达数千万次,而传统MCTS在同一时间内仅能完成数千次模拟。

alphago Zero的进一步突破在于其“单一神经网络”架构和强化学习机制,该版本将策略网络和价值网络合并为一个单一的残差卷积神经网络(ResNet),同时输出策略概率和局面价值,训练过程采用“自我对弈+强化学习”模式:初始网络通过随机落子进行自我对弈,生成大量棋局数据;然后利用这些数据通过策略梯度算法优化网络参数,每一步棋的奖励由最终胜负结果决定(胜者+1,负者-1),这种端到端的学习方式使得 alphago Zero能够自主探索围棋的深层规律,无需任何人类知识输入,在训练40天后, alphago Zero以100:0的比分击败了 alphago Lee,展示了其强大的自主学习能力。

从技术细节看, alphago的神经网络采用了多层残差结构和批量归一化(Batch Normalization)技术,有效解决了深层网络训练中的梯度消失问题,输入层将19×19的棋盘状态编码为多个特征平面,包括当前落子位置、历史落子信息等,每个平面维度为19×19,通过卷积层提取空间特征,输出层分为两个分支:策略分支通过全连接层输出361个可能落子点的概率分布;价值分支输出一个标量值表示胜率,在训练过程中, alphago采用了异步分布式训练框架,利用多个GPU并行计算加速网络优化,同时通过经验回放(Experience Replay)机制提高数据利用效率。

alphago的技术创新还体现在其平衡探索与利用的搜索策略上,在MCTS中,每个节点的访问次数和胜率通过UCT(Upper Confidence Bound 1 applied to Trees)公式进行权衡,既优先选择胜率高的节点(利用),又兼顾探索较少访问的节点(探索),策略网络的引入进一步优化了这一过程,使得搜索能够更聚焦于有潜力的分支。 alphago还引入了“dropout”技术 during inference,通过随机丢弃部分神经元来增加搜索的多样性,避免陷入局部最优解。

alphago的成功还得益于其高效的计算资源利用,在 alphago Lee版本中,使用了48个TPU(张量处理单元)进行神经网络计算,并配备了1202个CPU核心负责MCTS的并行搜索,这种异构计算架构充分发挥了TPU在矩阵运算上的优势,以及CPU在树搜索并行化中的灵活性,而在 alphago Zero中,计算资源进一步优化,仅使用4个TPU即可实现高效训练,证明了其算法的高效性。

从围棋规则的特殊性来看, alphago的技术突破还在于解决了高分支因子和长时依赖问题,围棋的合法落子点可达250个以上,远超国际象棋的35个,且对局长度通常超过150步。 alphago通过策略网络将搜索空间压缩到前N个候选落子点(如N=10),大幅降低了计算复杂度;价值网络能够评估长远的局势变化,克服了传统算法难以处理长时依赖的缺陷,在“第37手神之一手”中, alphago选择了一个看似违背常规但最终被证明是优势的落子点,正是价值网络对长远局势的精准判断。

alphago的技术亮点还体现在其可扩展性上,其核心框架不仅适用于围棋,还可迁移到其他领域,如将棋、星际争霸等。 alphastar在星际争霸中的应用,通过改进MCTS以处理部分可观测信息和实时决策问题,进一步验证了该框架的通用性,这种跨领域的适应性,得益于 alphago对“状态-动作”空间建模的通用性设计,以及深度强化学习方法的灵活性。

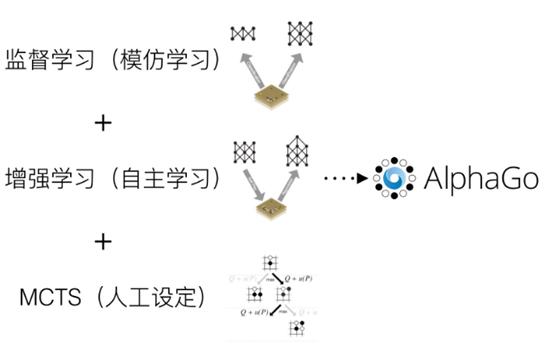

alphago的技术发展历程也反映了人工智能算法的演进路径:从依赖人类知识的监督学习,到结合自我对弈的强化学习,再到完全自主的 alphago Zero模式,这一演进不仅提升了围棋AI的水平,更推动了深度强化学习在复杂决策问题中的应用研究,其核心技术,如 guided MCTS、残差神经网络、分布式训练等,已成为现代AI系统的标准组件,影响深远。

相关问答FAQs:

-

问: alphago与 alphago Zero的主要区别是什么?

答: alphago依赖人类棋手数据进行监督学习训练策略网络,而 alphago Zero完全通过自我对弈生成数据,采用“单一神经网络+强化学习”模式,无需任何人类知识输入。 alphago Zero将策略网络和价值网络合并,训练效率更高,性能也显著超越 alphago Lee。 -

问: alphago的蒙特卡洛树搜索与传统MCTS有何不同?

答: 传统MCTS通过随机模拟(rollout)评估局面,计算效率低且评估精度差; alphago则用策略网络指导搜索方向(优先探索高概率落子点),并用价值网络直接输出局面胜率,替代了随机模拟,这种“ guided MCTS”大幅提升了搜索效率和评估准确性,是 alphago战胜人类棋手的关键技术之一。