Siri语音技术的实现离不开底层硬件的强力支撑,从麦克风阵列到神经网络引擎,每一代硬件的升级都推动着Siri交互体验的质的飞跃,苹果在硬件端的设计始终围绕“高效拾音、精准处理、快速响应”三大核心目标,通过多模块协同工作,将语音指令转化为即时可用的操作指令。

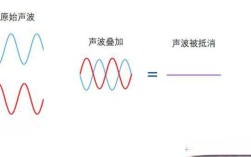

在拾音环节,硬件层面的麦克风阵列是Siri的“耳朵”,以iPhone为例,其通常搭载2-4个麦克风,通过波束成形技术(Beamforming)实现定向拾音,具体而言,麦克风阵列会实时分析声波来源方向,自动增强来自用户语音的信号,同时过滤环境噪音,在嘈杂的公共场所,Siri仍能准确捕捉“Hey Siri”唤醒词,关键就在于硬件级降噪算法与麦克风布局的优化,部分设备还配备骨传导传感器或 proximity sensor,通过识别人声振动或面部靠近状态,进一步降低误唤醒率,提升拾音精准度。

语音指令的本地处理能力则依赖于苹果自研的芯片架构,自A11 Bionic芯片引入神经网络引擎(Neural Engine)后,Siri的唤醒词检测和部分指令处理开始向端侧迁移,A15仿生芯片的神经网络引擎具备每秒15.8万亿次运算能力,可在设备本地完成“Hey Siri”唤醒词的实时识别,无需将原始音频上传至云端,既降低延迟,又保护用户隐私,对于更复杂的指令,如“设置明天早上7点的闹钟”,Siri会结合本地语义理解与云端协同处理,其中芯片的机器学习加速单元(ML Accelerator)负责提取语音特征,快速匹配预置的指令模板,大幅缩短响应时间。

存储与内存硬件同样影响Siri的交互流畅度,现代iPhone配备的统一内存(RAM)容量已达6GB以上,为Siri提供了充足的运行空间,确保多任务场景下语音指令的即时响应,内置存储器的读写速度优化,使得Siri可快速调用本地数据(如联系人、日历信息),实现“即说即现”的反馈效果,当用户询问“今天有什么日程”时,Siri能在毫秒级内访问本地存储的日历数据,无需等待云端加载。

硬件与软件的深度协同是Siri技术的关键,苹果采用“硬件预埋+软件迭代”的模式,在新一代芯片中预留专用指令集,加速语音信号的编解码与特征提取,M系列芯片在Mac上的应用,使得MacBook的Siri支持更连续的语音指令处理,结合T安全芯片,确保语音数据在硬件加密下的安全传输,苹果生态设备的硬件联动(如HomePod的麦克风阵列与iPhone的接力)进一步扩展了Siri的使用场景,实现跨设备的无缝语音控制。

| 硬件模块 | 核心功能 | 技术代表案例 |

|---|---|---|

| 麦克风阵列 | 定向拾音、降噪、唤醒词识别 | 波束成形技术、骨传导传感器、环境噪声自适应算法 |

| 神经网络引擎 | 本地端AI加速、语音特征提取、唤醒词实时检测 | A15/M2芯片的16核神经网络引擎,支持15.8 TOPS算力 |

| 统一内存 | 提供高速运行空间,保障多任务指令流畅处理 | iPhone 13 Pro的6GB LPDDR5内存,降低语音指令延迟 |

| 安全芯片 | 加密语音数据、保护用户隐私 | T2/M系列芯片集成Secure Enclave,实现语音数据硬件级加密 |

相关问答FAQs

Q1:为什么有时Siri在嘈杂环境中无法被唤醒?

A:Siri的唤醒成功率受硬件麦克风阵列与环境噪音的双重影响,若环境中噪音频率与唤醒词频率接近(如高频鸣笛),可能导致麦克风拾音混淆,设备麦克风若被遮挡(如手机装在密闭口袋),也会影响拾音效果,建议在相对安静的环境下使用,或确保麦克风未被遮挡。

Q2:Siri的语音识别精度是否与设备硬件型号有关?

A:是的,高端设备(如iPhone 14 Pro搭载A16芯片)拥有更强的神经网络引擎和更大内存,可支持更复杂的本地语音模型,识别准确率显著高于旧款设备,A16芯片的神经网络引擎能处理更长的语音上下文,减少指令理解偏差。