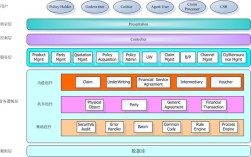

iPhone的AR技术实现是一个融合硬件、软件和算法的复杂系统工程,其核心在于通过设备的多传感器协同和强大的计算能力,将虚拟信息与现实世界精准融合,为用户提供沉浸式体验,从技术架构来看,iPhone的AR实现可分为感知、渲染、交互三个核心环节,每个环节都依赖于苹果自研的技术栈和硬件优化。

在感知环节,iPhone依赖多种传感器构建对现实世界的理解,首先是摄像头阵列,包括广角、超广角和长焦镜头,这些镜头不仅负责捕捉图像,还通过深度感知技术(如iPhone 12 Pro及后续机型上的LiDAR激光雷达)实现高精度距离测量,LiDAR传感器通过发射激光脉冲并测量反射时间,可生成深度图,精度达厘米级,大幅提升AR场景中的空间定位精度,其次是惯性测量单元(IMU),包含加速度计和陀螺仪,实时追踪设备的姿态和运动状态,确保虚拟物体与用户视角保持同步,iPhone还利用环境光传感器和麦克风辅助感知光照条件和空间音频环境,为渲染提供更逼真的物理参数,这些传感器数据通过苹果的传感器融合算法进行处理,降低噪声干扰,提升空间感知的稳定性。

渲染环节是AR体验的关键,苹果通过自研的ARKit框架和Metal图形API实现高性能渲染,ARKit负责处理空间映射、场景识别和运动追踪等核心任务,其中空间映射技术通过摄像头和LiDAR扫描环境,构建三维点云模型,使虚拟物体能够与真实表面交互(如放置在桌面上并投射阴影),场景识别则可预定义平面(如地面、墙面)或识别特定物体(如图片、海报),触发相应的AR内容,在图形渲染方面,Metal充分利用苹果A系列仿生芯片的GPU能力,支持实时光线追踪、动态阴影和反射效果,使虚拟物体更自然地融入现实环境,iPhone 12 Pro系列后的芯片支持硬件加速的深度学习,用于实时分割前景和背景,进一步提升虚拟与现实的融合度。

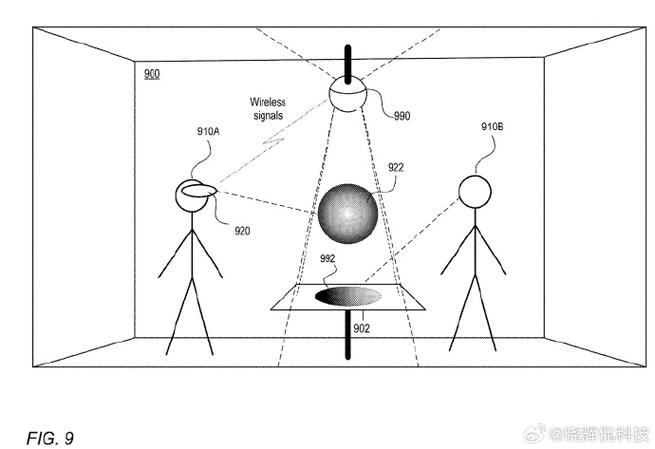

交互环节则结合了触控、视觉和音频反馈,实现自然的人机交互,苹果通过TrueDepth摄像头系统实现面部追踪和手势识别,用户可通过眼神注视或手指动作控制虚拟物体(如iOS 17中的“抬眼激活”功能),ARKit支持空间音频技术,利用设备的陀螺仪和加速度计计算声音方向,使虚拟声音随用户移动而变化,增强沉浸感,iPhone的触觉引擎可模拟不同材质的触感反馈,例如点击虚拟按钮时产生相应的震动,提升交互的真实性。

硬件与软件的深度协同是iPhone AR技术优势的核心,苹果从A11仿生芯片开始集成神经网络引擎(ANE),专门用于加速机器学习任务,如物体检测和姿态估计,ARKit 6及以上版本支持“持久AR体验”,允许用户在不同会话中保持空间定位一致性,这依赖于设备对环境特征的长期学习和存储,苹果还通过“现实世界格式”(USDZ)文件标准,简化3D模型的创建和共享,推动AR生态发展。

相关问答FAQs

Q1:iPhone的AR技术是否需要网络连接?

A1:部分AR功能可在离线状态下使用,如基于本地传感器追踪的简单AR体验(如放置虚拟物体),但需要网络连接的功能包括:云端空间映射、在线场景识别、实时多人协作AR以及需要访问在线3D模型库的复杂应用,LiDAR传感器等硬件功能完全依赖本地计算,不依赖网络。

Q2:为什么旧款iPhone无法体验最新的AR功能?

A2:旧款iPhone的AR功能受限主要受硬件和系统两方面制约,硬件上,缺乏LiDAR传感器、神经网络引擎或高性能GPU(如A12仿生芯片以上),无法支持深度感知、实时光线追踪等高级特性,系统层面,ARKit新版本需要iOS新系统的支持,而旧款设备可能无法升级最新系统,导致无法调用新的AR API和算法优化,iOS 17的“抬眼激活”AR功能需要TrueDepth摄像头和A12仿生芯片以上的支持。