Facebook作为全球最大的社交网络平台之一,每天产生的数据量以PB级别计算,这些数据包括用户发布的文本、图片、视频,用户之间的互动行为(点赞、评论、分享),以及用户资料、位置信息等海量结构化和非结构化数据,如何高效存储、处理和分析这些数据,成为Facebook技术团队的核心挑战,其背后的大数据技术体系也成为了业界的标杆,Facebook的大数据技术栈以开源技术为基础,并结合自身业务需求进行了深度定制和创新,形成了从数据采集、存储、处理到分析与应用的全链路解决方案。

在数据采集与存储层面,Facebook构建了全球分布式的数据采集系统,通过客户端SDK和服务端日志收集,实时捕获用户行为数据,针对海量数据的存储,Facebook开发了多种分布式存储系统:对于海量的图片和视频等非结构化数据,Haystack存储系统提供了高效的存储和检索能力,通过索引和缓存机制优化访问性能;对于实时日志数据,LogDevice提供了高吞吐、低延迟的分布式日志存储服务;而对于结构化数据,MyScale等分布式数据库支撑了业务系统的快速查询需求,Facebook还广泛使用了HDFS作为离线数据存储的基础,配合自研的F4文件系统,实现了存储资源的弹性扩展和成本优化。

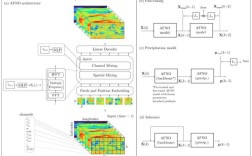

在数据处理与计算框架方面,Facebook的核心是Apache Spark和Presto的组合,Spark作为统一的 analytics 引擎,被广泛应用于批处理、机器学习和流处理场景,其内存计算特性大大提升了数据处理效率;Presto则作为Facebook自研的分布式SQL查询引擎,专为实时交互式查询设计,能够在秒级响应TB级数据的分析需求,支撑了数据分析师的即席查询,对于实时流处理,Facebook基于Apache Flink构建了流计算平台,实现了用户行为数据的实时监控、推荐系统的实时更新等场景,Facebook还开发了Bullseye等机器学习平台,将Spark MLlib和TensorFlow等框架集成,支撑了推荐算法、广告投放、内容审核等核心业务的模型训练与部署。

在数据应用与价值挖掘层面,Facebook的大数据技术深度融入业务场景,在推荐系统方面,通过分析用户的社交关系、兴趣偏好和行为序列,利用Spark和Flink实时计算用户画像和内容热度,实现Feed流和视频推荐的个性化;在广告系统方面,通过Presto对海量用户数据进行实时查询,结合机器学习模型精准匹配广告与用户,提升广告转化效率;在安全与风控领域,通过流计算平台实时监测异常行为,利用图计算技术分析社交网络中的虚假账号和恶意信息,Facebook还通过大数据分析优化产品体验,比如通过A/B测试验证新功能效果,通过用户行为数据洞察产品改进方向。

为了更直观地展示Facebook大数据技术的核心组件及其功能,以下表格总结了关键技术的应用场景:

| 技术组件 | 主要功能 | 应用场景 |

|---|---|---|

| Apache Spark | 统一批处理、机器学习和流计算引擎 | 离线数据分析、模型训练 |

| Presto | 分布式SQL查询引擎,支持实时交互式查询 | 数据分析师即席查询、BI报表 |

| Apache Flink | 高吞吐、低延迟的流计算处理 | 实时推荐、广告竞价、风控监控 |

| Haystack | 海量图片视频的分布式存储与检索 | 存储与快速访问 |

| LogDevice | 高可用分布式日志存储系统 | 实时日志收集与故障排查 |

| MyScale | 分布式关系型数据库,支持高并发查询 | 业务系统数据存储与实时查询 |

相关问答FAQs:

Q1:Facebook如何保证海量数据处理的实时性?

A1:Facebook通过多层次的实时计算架构保证数据处理实时性:在数据采集层,采用Kafka等消息队列实现高吞吐数据接入;在计算层,基于Apache Flink构建流计算平台,支持毫秒级延迟的数据处理;在查询层,Presto引擎针对实时交互式查询进行优化,能够在秒级返回TB级数据结果,通过内存计算和分布式架构设计,确保了系统在高并发场景下的稳定性。

Q2:Facebook大数据技术栈与开源社区的关系是什么?

A2:Facebook既是开源技术的重度使用者,也是重要的贡献者,其大数据技术栈以开源项目为基础,如Hadoop、Spark、Flink等,并根据业务需求进行深度定制和创新,例如将Presto开源供社区使用,LogDevice也贡献给了Apache基金会,Facebook通过开源回馈社区,推动技术生态发展,形成了“使用-创新-开源”的良性循环,例如Cassandra、Thrift等项目最初均由Facebook发起并开源。