核心问题:串扰

要理解Vectoring,首先要明白它要解决的核心问题——串扰。

-

什么是串扰?

- 在通信线缆中(如电话线、网线),多根导线是平行布放的的。

- 当电流(信号)在其中一根线缆上传输时,会产生一个电磁场。

- 这个电磁场会“感应”或“干扰”到旁边线缆中的信号,导致信号失真。

- 这种“邻居”之间的信号干扰,就叫做串扰。

-

串扰为什么是个大问题?

- 信号衰减:串扰就像背景噪音,它会“淹没”掉微弱的原始信号,导致接收端无法正确解码。

- 速率下降:为了抵抗串扰,设备必须降低传输速率或增加功率,但这又会带来新的问题(如发热、干扰其他无线电业务)。

- 距离限制:串扰效应会随着频率的升高而急剧增强,VDSL2使用非常高的频段(可达30MHz)来传输高速数据,因此它对串扰极其敏感。

-

串扰的两种类型:

- 远端串扰:来自用户端(CPE,如你家光猫)的干扰,因为用户端距离远,干扰相对较弱。

- 近端串扰:来自同一机柜内其他用户的干扰,这是VDSL2最致命的敌人,因为所有用户都连接到同一个DSLAM(数字用户线路接入 multiplexer,运营商端设备),他们的线路在“最后一公里”的起点非常靠近,产生的干扰最强,直接影响所有用户的速率。

简单比喻: 想象一个安静的图书馆,每个人都在小声交谈(正常数据传输),如果旁边有一个人在用大喇叭喊话(近端串扰),那么周围的人就完全听不清自己想说什么了,Vectoring技术,就像是图书馆管理员,让那个用大喇叭的人小声说话,并且还能“过滤”掉所有其他人的杂音,让整个图书馆恢复安静。

解决方案:VDSL Vectoring(矢量技术)

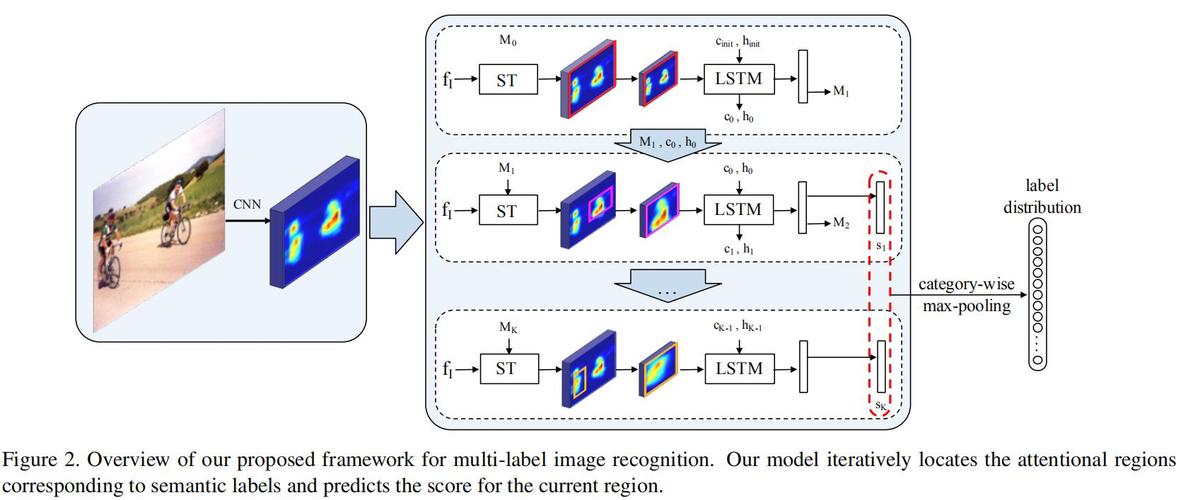

Vectoring技术的核心思想是:既然串扰是可预测的,那么我们就可以主动地“消除”它。

- 工作原理:

- 集中处理:Vectoring技术只在局端(DSLAM设备)实现,用户家里的光猫/Modem不需要任何改动。

- 信号预编码:DSLAM设备内部有一个强大的信号处理器,它同时管理着所有连接到它的VDSL线路。

- 建模与预测:DSLAM会实时监测所有线路之间的串扰情况,并建立一个精确的数学模型,来预测每条线路对其他线路会产生什么样的干扰。

- 反向预补偿:在进行数据发送之前,DSLAM会根据预测模型,主动对信号进行微调(预编码),它会“预知”到自己的信号会给邻居带来怎样的干扰,于是就在发送信号的同时,发送一个与干扰信号相反的“反向补偿信号”。

- 消除干扰:当信号传输到用户端时,原本应该存在的串扰,已经被这个“反向补偿信号”抵消掉了,这样,接收端(你家)就只收到了干净、无干扰的原始信号。

简单比喻(续): 图书馆管理员(Vectoring DSLAM)知道那个用大喇叭的人(近端串扰源)要喊什么内容,在对方喊话之前,管理员就对着他的麦克风播放一个相反的声音(反向预编码),这样当他的声音传出来时,两个声音就相互抵消了,周围的人听到的就又恢复了安静。

Vectoring带来的巨大好处

-

显著提升速率和距离

- 这是Vectoring最直接的好处,通过消除串扰,线路的“信噪比”得到极大改善。

- 速率提升:在300米到500米的距离内,Vectoring可以将VDSL2的速率提升2到3倍,没有Vectoring时,500米距离可能只有30-50Mbps;启用Vectoring后,可能轻松达到100Mbps甚至更高。

- 距离延长:在更远的距离(如1公里),速率提升的倍数可能更高,因为串扰是限制速率的主要瓶颈。

-

实现“对称”高速率

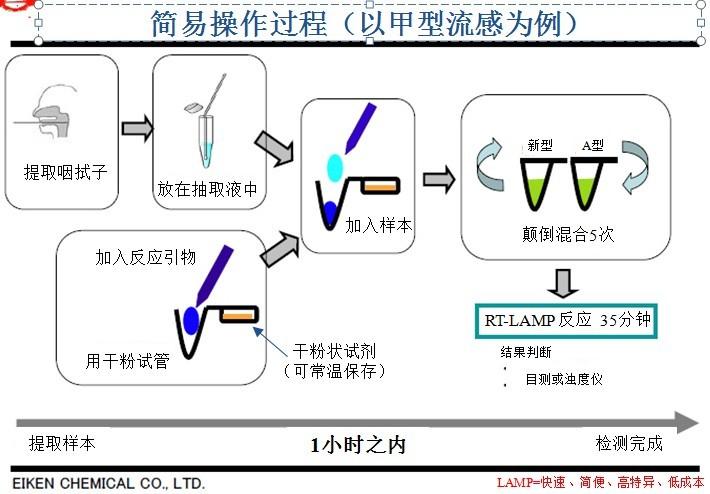

(图片来源网络,侵删)

(图片来源网络,侵删)- 传统ADSL/非Vectoring VDSL是“非对称”的,下载远快于上传。

- Vectoring技术使得上下行速率可以非常接近,实现“对称宽带”,这对于需要大量上传数据的业务(如视频会议、云办公、在线游戏、家庭NAS)至关重要。

-

提高稳定性和可靠性

消除了串扰这个最大的不稳定因素,连接质量更稳定,掉线率更低,延迟更低。

-

频谱效率更高

由于串扰被抑制,可以使用更高、更宽的频谱来传输数据,进一步挖掘铜缆的潜力。

Vectoring的挑战与限制

-

需要设备协同工作

- Vectoring要求同一捆线缆内的所有用户都必须使用支持Vectoring的设备,如果有一个“不合作”的用户(比如还在用老旧的非Vectoring Modem),他的线路就会像一个巨大的“干扰源”,导致整个线束的Vectoring效果失效,甚至拖累所有其他用户。

- 运营商在部署Vectoring时,通常会对一个区域进行“整体割接”。

-

部署成本高

需要更换支持Vectoring功能的DSLAM设备,这是一笔巨大的前期投资。

-

监管限制

Vectoring通过“预编码”技术,可能会对其他无线电业务(如短波广播)产生微弱影响,在部署前需要获得无线电管理部门的许可,并严格限制其发射功率。

-

非终极方案

Vectoring是“榨干”铜缆潜力的最后一步,它无法改变铜缆物理衰减的根本限制,对于超过1公里的线路,速率提升依然有限,它被视为从铜缆时代过渡到全光纤时代的关键桥梁技术。

Vectoring的地位与未来

- G.fast的前奏:Vectoring是G.fast技术的基础,G.fast使用更高频段(可达212MHz),对串扰的敏感度比VDSL2高得多,因此必须依赖Vectoring技术才能工作。

- FTTC的“神助攻”:Vectoring主要应用在FTTC(Fiber to the Curb,光纤到路边)网络中,在这种架构下,光纤只铺设到小区或路边的交接箱,最后几十米到几百米仍然是铜缆(电话线),Vectoring让这种“光纤+铜缆”的混合模式在短期内具备了与光纤到户竞争的实力。

- 过渡角色:随着FTTH(光纤到户)成本的下降和普及,Vectoring作为一种过渡技术,其重要性正在逐渐减弱,但在全球范围内,仍有大量地区在利用Vectoring来升级现有的铜缆网络,以提供更高速、更稳定的宽带服务。

| 特性 | 描述 |

|---|---|

| 技术名称 | VDSL Vectoring (VDSL 矢量技术) |

| 核心问题 | 消除铜缆中因线路靠近而产生的近端串扰 |

| 工作原理 | 在局端对信号进行预编码,主动预测并抵消对邻居线路的干扰 |

| 主要优势 | 速率翻倍、实现对称带宽、连接更稳定 |

| 主要限制 | 需区域内所有用户设备协同、部署成本高、非终极方案 |

| 主要应用 | FTTC网络,是G.fast技术的基础 |

| 未来地位 | 从铜缆到光纤过渡的关键桥梁技术 |