NVLINK技术是由NVIDIA推出的一种高速互连技术,旨在为高性能计算(HPC)、人工智能(AI)训练和专业图形处理等领域提供比传统PCIe总线更高的带宽和更低的延迟,该技术的核心目标是通过突破传统总线带宽的限制,实现多个GPU之间更高效的数据交换,从而提升多GPU系统的整体性能,满足现代计算密集型应用对数据处理能力日益增长的需求。

NVLINK技术的诞生背景与GPU计算能力的飞速发展密切相关,随着GPU核心数量的不断增加和计算性能的持续提升,传统PCIe总线的带宽逐渐成为制约多GPU系统性能发挥的瓶颈,在深度学习训练中,大规模模型往往需要多个GPU协同工作,GPU之间需要频繁交换中间数据和梯度信息,PCIe 3.0 x16的带宽(约16 GB/s)已经难以满足需求,而PCIe 4.0 x16的带宽(约32 GB/s)在面对未来更高性能的GPU时也可能捉襟见肘,NVLINK技术通过提供更高的传输速率和专门的通信通道,有效解决了这一问题,使得多个GPU能够更紧密地协同工作,接近单GPU的线性扩展能力。

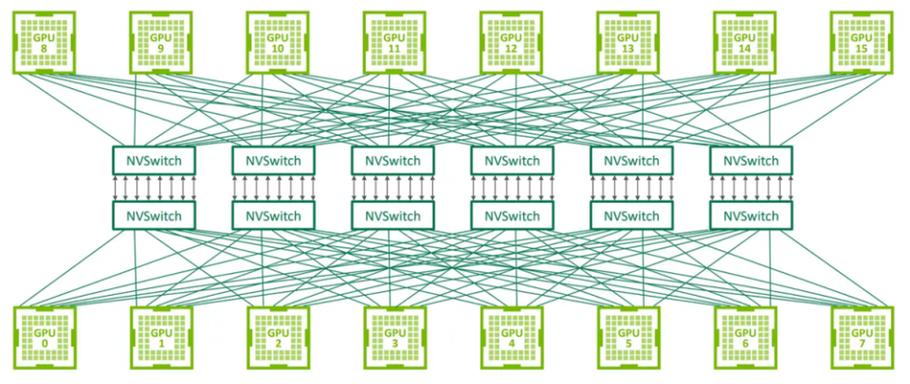

从技术架构来看,NVLINK并非对PCIe的简单替代,而是一种与PCIE共存的高性能互连方案,它通常通过GPU上的专用引脚实现连接,与PCIe通道物理隔离,从而避免了总线争用问题,以NVIDIA最新的NVLINK 4.0技术为例,其单通道带宽可达12.5 GB/s,是PCIe 4.0 x16(32 GB/s)的近两倍,而高端GPU(如H100)支持多条NVLINK通道,总带宽可高达900 GB/s以上,这种高带宽特性使得GPU之间的数据传输延迟大幅降低,例如在AI训练中,模型参数的同步时间可以从PCIe时代的毫秒级降低到NVLINK时代的微秒级,显著提升了训练效率。

NVLINK技术的实现依赖于硬件和软件的协同支持,在硬件层面,支持NVLINK的GPU需要配备专门的NVLINK控制器和物理接口,例如NVIDIA的NVLink Bridge可以连接两块GPU,实现点对点的高速通信,在软件层面,NVIDIA提供了CUDA等编程工具,开发者可以通过NVLINK API直接管理GPU之间的数据传输,优化内存访问模式,NVLINK还支持多种拓扑结构,如环形、星形等,用户可以根据应用需求灵活配置GPU之间的连接方式,以实现最佳性能。

在实际应用中,NVLINK技术已经展现出显著的优势,在AI领域,基于NVLINK的多GPU服务器能够支持更大规模的模型训练,例如GPT-3等千亿参数模型的训练,就需要依赖NVLINK技术实现数百个GPU的高效协同,在科学计算中,NVLINK可以加速分子动力学模拟、气候建模等应用中海量数据的交换和处理,在专业图形渲染领域,NVLINK使得多GPU渲染节点能够实时处理复杂的3D场景,显著提升渲染效率,在影视特效制作中,使用NVLINK连接的多GPU系统可以将渲染时间从数周缩短至数天。

为了更直观地对比NVLINK与传统PCIe的性能差异,以下表格列举了不同代际技术的主要参数:

| 技术标准 | 单通道带宽 (GB/s) | 典型GPU配置带宽 (GB/s) | 延迟 (约) | 主要应用场景 |

|---|---|---|---|---|

| PCIe 3.0 x16 | 0 | 16 | 毫秒级 | 通用计算、消费级GPU |

| PCIe 4.0 x16 | 0 | 32 | 毫秒级 | 高性能计算、主流GPU |

| NVLink 3.0 | 0 | 300 (A100 GPU, 4通道) | 微秒级 | AI训练、HPC |

| NVLink 4.0 | 5 | 900 (H100 GPU, 72通道) | 微秒级 | 超大规模AI、科学计算 |

尽管NVLINK技术带来了诸多优势,但其应用也存在一定限制,支持NVLINK的GPU通常定位高端,成本较高,限制了其在消费级市场的普及,NVLINK的带宽优势需要通过优化的软件算法才能充分发挥,若应用程序未能充分利用GPU间通信,性能提升可能有限,NVLINK的拓扑设计和系统配置相对复杂,对用户的技术能力有一定要求。

随着GPU计算需求的持续增长,NVLINK技术也将不断演进,预计未来的NVLINK版本将进一步提升带宽,降低功耗,并支持更灵活的连接方式,NVIDIA可能会推出支持芯片间直接互连的NVLINK技术,实现多GPU模块化设计,进一步提升系统的可扩展性,随着异构计算的发展,NVLINK也可能与其他加速器(如CPU、FPGA)的互连技术融合,构建更统一的高性能计算平台。

相关问答FAQs:

-

问:NVLINK技术与PCIe技术有何本质区别?

答:NVLINK与PCIe的本质区别在于设计目标和通信机制,PCIe是一种通用的I/O互连技术,主要用于连接GPU与CPU、存储设备等,其带宽和延迟特性适合多种外设;而NVLINK是专为GPU间高速通信设计的专用技术,通过物理隔离的通道和更高的传输速率,实现GPU间直接、高效的数据交换,避免PCIe总线的争用和延迟瓶颈,更适合多GPU协同计算场景。 -

问:使用NVLINK技术是否需要特定的硬件和软件支持?

答:是的,硬件方面,需要使用支持NVLINK的GPU(如NVIDIA的A100、H100等数据中心GPU),并通过NVLINK Bridge或专用线缆连接;主板需要提供相应的NVLINK接口和供电支持,软件方面,需要安装NVIDIA驱动程序,并利用CUDA、NCCL(NVIDIA Collective Communications Library)等工具优化多GPU应用程序,以充分发挥NVLINK的高带宽优势。