alphago技术解析的核心在于其深度强化学习与蒙特卡洛树搜索(mcts)的深度融合,这一架构彻底突破了传统围棋ai依赖手工设计特征和固定评估函数的局限,通过端到端的学习实现了从策略评估到决策优化的全流程智能化,其技术体系可拆分为策略网络、价值网络、蒙特卡洛树搜索三大核心模块,辅以大规模自我对弈训练和迁移学习,共同构建了围棋领域的“超级大脑”。

策略网络是alphago实现高效落子的基础,包含两个子网络:监督学习策略网络(sl policy network)和rollout策略网络,sl policy网络通过学习人类职业棋手的约3000万步棋谱数据,掌握基础的落子模式,其结构为13层卷积神经网络(cnn),输入为19×19×17的棋盘状态(包含当前棋子颜色、历史落子信息等17层平面),输出为361个位置的先验概率分布,该网络虽然能快速筛选出合理落子点,但远非最优,仅作为mcts的先验引导,rollout策略网络则采用更轻量的5层cnn结构,用于在mcts的快速模拟中生成粗略的胜负概率,其计算速度是sl policy网络的1000倍,弥补了深度网络在模拟效率上的不足。

价值网络是alphago实现局面评估的关键突破,其核心功能是直接判断当前棋盘状态的胜率,该网络同样采用13层cnn结构,输入与策略网络一致的棋盘状态,输出为一个0到1之间的标量值,表示当前玩家获胜的概率,与传统的基于手工设计的“气”“目数”等评估函数不同,价值网络通过端到端学习自动提取局面特征,能够理解复杂的棋形组合、厚薄关系和潜在进攻机会,在训练阶段,价值网络通过自我对弈生成的3000万盘棋局数据,以“当前局面”为输入,“最终胜负”为标签进行监督学习,最终实现了对专业九段棋手局面判断能力的超越——测试显示其预测准确率高达57%,而传统评估函数仅为44%。

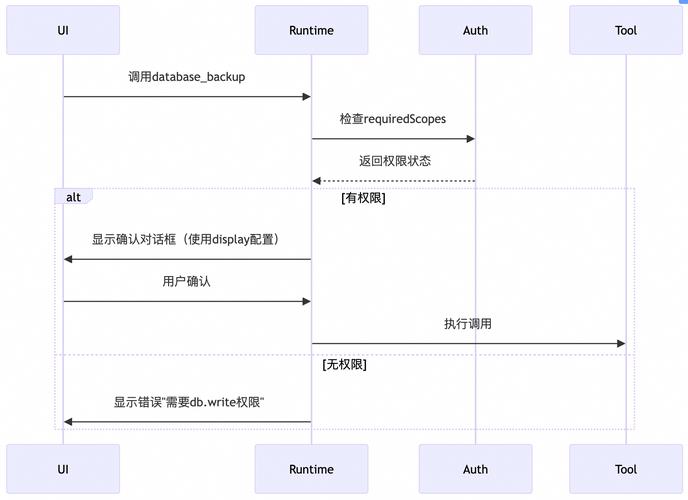

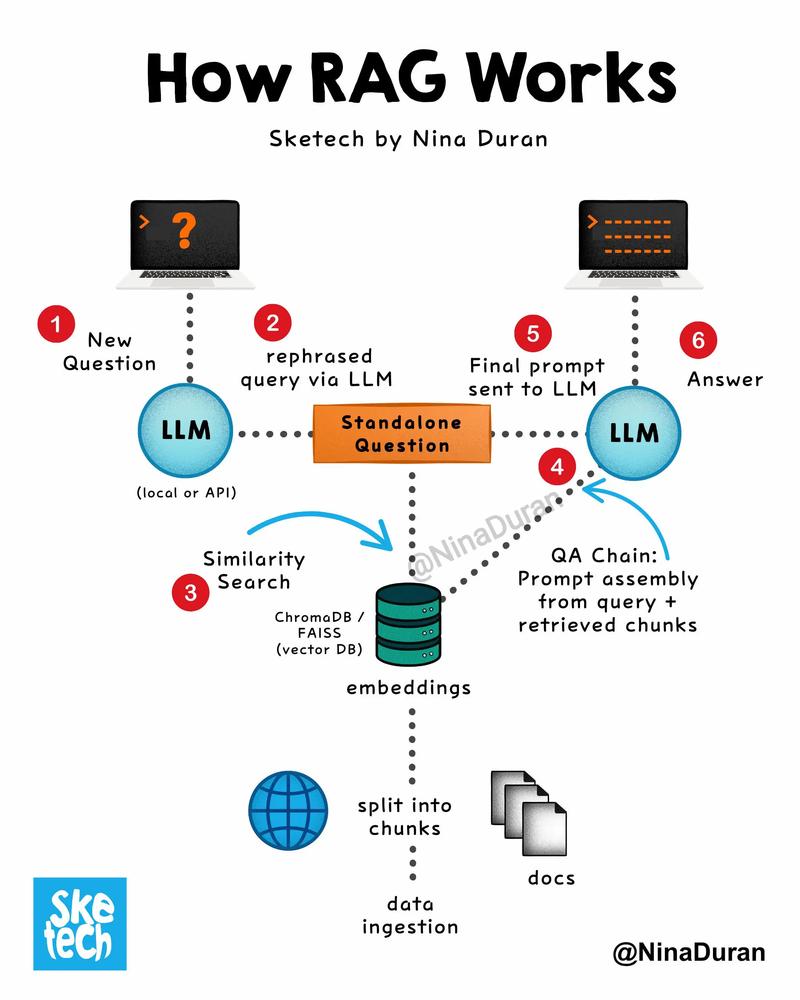

蒙特卡洛树搜索是alphago将策略网络与价值网络融合为决策核心的枢纽,传统mcts依赖随机模拟(rollout)来评估节点,计算效率低且评估精度差;alphago则通过“两阶段剪枝”大幅优化这一过程:在树的上层,策略网络提供先验概率分布,指导mcts优先探索高概率落子子树,避免无效搜索;在树的叶子节点,价值网络直接输出局面胜率,替代了耗时的随机模拟,具体而言,mcts通过四个步骤循环迭代:选择(selection)从根节点开始,依据uct(上置信界)公式选择最优子节点,该公式平衡了“探索”(先验概率)与“利用”(当前价值);扩展(expansion)当到达未扩展节点时,策略网络生成子节点先验概率;模拟(simulation)对叶子节点,价值网络直接输出胜率;反向传播(backpropagation)将胜率更新至路径上所有节点的访问次数和累计价值,通过数千次模拟,mcts最终选择访问次数最多的节点作为落子选择,这一过程将传统mcts的每步决策时间从分钟级缩短至秒级,且决策精度显著提升。

alphago核心模块功能对比 | 模块名称 | 结构特点 | 输入输出 | 核心作用 | 计算效率 | |----------------|------------------------|-------------------------|------------------------------|----------------| | sl策略网络 | 13层cnn | 棋盘状态→361维概率分布 | 提供落子先验引导 | 中等(约3ms/步)| | rollout策略网络| 5层cnn | 棋盘状态→简化概率分布 | 快速模拟(粗略评估) | 极高(约0.003ms/步)| | 价值网络 | 13层cnn | 棋盘状态→胜率标量 | 精确局面评估 | 中等(约2ms/步) | | mcts整合框架 | 树搜索+神经网络引导 | 概率分布+胜率→最优落子 | 决策优化与平衡探索利用 | 依赖模拟次数 |

alphago的训练流程分为三个阶段:通过监督学习训练sl策略网络,模仿人类棋手基础棋感;利用sl策略网络进行自我对弈,生成海量棋局数据(约3000万盘),训练价值网络学习局面判断;通过强化学习优化策略网络,以自我对弈的胜负作为奖励信号,通过策略梯度法调整网络参数,使策略网络逐渐超越人类水平,形成“alphago master”版本,这一过程中,迁移学习技术的应用至关重要:将初始训练的策略网络权重作为强化学习的起点,大幅减少了训练时间和数据需求。

alphago的技术突破不仅限于围棋领域,其核心思想为复杂决策问题提供了新范式,策略网络与价值网络的分工协作,解决了传统ai中“搜索效率”与“评估精度”的矛盾;而mcts与神经网络的深度融合,则开创了“基于学习的搜索”方法,后续在蛋白质折叠(alphafold)、游戏ai(open five five)等领域得到广泛应用,尽管alphago在围棋领域已无对手,但其技术演进仍在继续——alphago zero通过完全摒弃人类数据,仅通过自我对弈实现从零到一的突破,进一步验证了强化学习在通用人工智能中的潜力。

相关问答FAQs: Q1:alphago的策略网络和价值网络有何本质区别? A1:策略网络和价值网络的本质区别在于功能定位和输出形式,策略网络专注于“动作选择”,输出的是在当前局面下各个落子位置的先验概率,指导搜索方向;而价值网络专注于“状态评估”,输出的是当前局面的胜率标量,用于判断局面的优劣,从结构上看,两者虽均采用cnn,但输出层激活函数不同(策略网络用softmax,价值网络用sigmoid),且训练数据来源差异——策略网络初期依赖人类棋谱监督学习,价值网络则通过自我对弈的胜负结果进行训练。

Q2:alphago与之前的围棋ai(如zen)相比,技术突破点在哪里? A2:alphago与zen等传统围棋ai的核心突破在于从“基于规则的搜索”转向“基于学习的搜索”,zen主要依赖手工设计的评估函数(如棋形、目数统计)和固定搜索算法,其能力上限受限于规则设计的完备性;而alphago通过策略网络和价值网络自动学习评估标准,且mcts通过神经网络引导实现了“有方向的搜索”,大幅提升了搜索效率和质量,alphago的自我对弈强化学习机制使其能够持续进化,而传统ai依赖人工调整规则,难以实现自我迭代。