这项技术在 Android 平台上已经发展得相当成熟,从简单的手势识别到复杂的基于 AI 的姿态估计,为开发者提供了丰富的工具来创造更智能、更人性化的交互体验。

下面我将从 核心技术、发展历程、应用场景、开发实践 四个方面进行详细阐述。

核心技术分类

Android 的动作识别技术主要可以分为以下几大类:

基于传感器(运动传感器)的传统识别

这是最基础也是最核心的识别方式,主要依赖于设备内置的 运动传感器。

-

核心传感器:

(图片来源网络,侵删)

(图片来源网络,侵删)- 加速度计: 测量设备在三维空间中的线性加速度(包括重力),可以用来检测设备的晃动、摇动、抬升、下落等动作。

- 陀螺仪: 测量设备绕三个轴的旋转速率,可以用来精确识别旋转、扭转等动作。

- 磁力计: 测量地球磁场方向,通常用于辅助确定设备的绝对朝向(指南针功能)。

-

识别原理: 通过监听这些传感器返回的原始数据流,分析其特征值(如幅度、频率、方向变化),来判断用户执行了什么动作。

- 摇一摇: 检测加速度计数据在短时间内出现剧烈的、无规律的变化。

- 设备旋转: 结合陀螺仪和加速度计数据,判断设备是否被扭转。

- 放置在桌面: 通过检测重力加速度的方向,判断设备是平放还是竖放。

-

特点:

- 优点: 实时性高、功耗低、几乎所有 Android 设备都支持。

- 缺点: 识别的动作类型有限,精度受设备放置方式影响大,难以区分复杂或细微的动作。

基于计算机视觉的识别

随着摄像头性能的提升和计算能力的增强,基于视觉的动作识别成为主流,尤其是复杂动作的识别。

-

核心组件:

(图片来源网络,侵删)

(图片来源网络,侵删)- 摄像头: 捕捉视频流或图像。

- Android ML Kit / MediaPipe: Google 提供的强大工具库,极大地简化了开发难度。

- 自定义 TensorFlow Lite 模型: 对于高度定制化的需求,开发者可以训练自己的模型并在设备上运行。

-

主要技术方向:

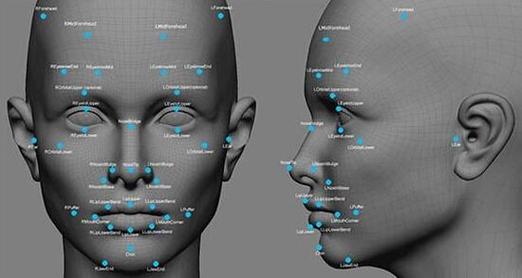

- 姿态估计: 这是当前最热门和强大的技术,它能通过摄像头画面,实时检测出人体关键点(如关节、五官)的位置。

- 代表技术: MediaPipe Pose,它可以在移动设备上实时、高效地检测出33个人体关键点。

- 识别原理: 通过分析这些关键点之间的相对位置、距离和运动轨迹,来判断具体的动作,识别“举手”、“拍手”、“下蹲”、“瑜伽姿势”等。

- 手势识别: 识别手部的特定形状或动作。

- 代表技术: MediaPipe Hands,可以检测到手掌和21个关键点。

- 识别原理: 通过分析手指的弯曲、伸展以及手掌的形状来识别“OK”、“点赞”、“比心”、“数字”等手势。

- 活动识别: 通过分析视频序列的整体运动模式来识别宏观活动,如“走路”、“跑步”、“坐着”、“站立”。

- 代表技术: ML Kit 的活动识别器,它通常结合了传感器数据和视觉数据,通过一个预训练的模型来识别这些活动。

- 对象检测与跟踪: 识别画面中的特定物体(如一个球)并跟踪其运动轨迹,从而推断出“抛接球”等动作。

- 姿态估计: 这是当前最热门和强大的技术,它能通过摄像头画面,实时检测出人体关键点(如关节、五官)的位置。

-

特点:

- 优点: 识别能力极强,可以理解复杂、细微的全身或手部动作,用户体验直观。

- 缺点: 对摄像头质量和光线有一定要求,计算量较大(但 TFLite 和 MediaPipe 已高度优化),功耗相对较高。

基于混合模式的识别

这是最先进和最准确的方式,结合了传感器和视觉的优势。

-

原理: 将来自传感器的数据和来自摄像头的视觉数据融合到一个机器学习模型中,ML Kit 的活动识别器就是这样做的。

- 传感器数据:可以提供设备本身的运动状态,不受视角限制。

- 视觉数据:可以提供人体姿态和环境的丰富信息。

- 融合模型:可以综合两种信息源,做出比单一数据源更鲁棒、更准确的判断。

-

特点:

- 优点: 精度和鲁棒性最高,能应对更复杂的场景(如遮挡、不同视角)。

- 缺点: 实现复杂度最高,对设备性能要求也最高。

发展历程

Android 的动作识别技术经历了从简单到复杂、从后台到前台的发展过程。

-

早期阶段 (API 1-8): 主要提供

SensorManager和基础传感器(加速度计、磁场传感器),开发者需要手动处理原始数据,实现如“摇一摇”等简单功能,这是最原始的传感器识别。 -

发展阶段 (API 9-18): 引入了

TYPE_GYROSCOPE(陀螺仪),使得旋转识别成为可能。SensorEvent的处理机制更加完善,但开发者仍需面对大量的数据滤波和算法工作。 -

爆发阶段 (API 19+):

- Camera2 API: 提供了对摄像头更底层、更强大的控制,为计算机视觉应用铺平了道路。

- Google Play Services 推出 ML Kit: 这是里程碑式的事件,它将复杂的机器学习模型封装成简单的 API,让普通开发者也能轻松实现人脸检测、文字识别、条码扫描以及活动识别,这标志着基于混合模式的动作识别技术走向大众化。

- MediaPipe 的开源: Google 开源了 MediaPipe,它提供了一系列高性能、跨平台的解决方案,如 Pose、Hands、Face Mesh 等,这使得开发者可以轻松地在 App 中集成实时的人体姿态和手势识别功能,无需深厚的机器学习背景。

-

成熟阶段 (:

- TensorFlow Lite (TFLite): 成为移动端部署 AI 模型的标准,开发者可以轻松地在 Google Colab 等平台训练模型,然后通过 TFLite 部署到 Android 设备上,实现完全定制化的动作识别。

- ARCore 的普及: AR 应用大量使用姿态估计和运动跟踪技术,反向推动了相关技术在 Android 平台上的成熟和优化。

主要应用场景

动作识别技术已经渗透到我们使用的各类 App 中:

-

健康与健身:

- 健身 App: 自动识别你的深蹲、俯卧撑、平板支撑等动作,并计数、纠正姿势(如 Keep, Nike Training Club)。

- 跑步/骑行 App: 结合 GPS 和传感器,识别你的跑步状态(走路、跑步、停下)。

- 瑜伽/舞蹈 App: 实时分析你的体式是否标准。

-

AR/VR 与游戏:

- 体感游戏: 通过摄像头捕捉全身动作,实现无手柄的游戏交互。

- AR 互动: 在 AR 中,虚拟物体可以与用户的身体或手势进行交互,用手“抓住”一个虚拟的 3D 模型。

-

人机交互:

- 手势控制: 在不接触屏幕的情况下,用手势控制音乐播放、切换图片、接听电话。

- 隔空操作: 通过特定手势(如挥手)实现翻页等操作。

-

安防与监控:

- 跌倒检测: 通过姿态估计算法,自动检测老人或独居者是否意外跌倒,并发出警报。

- 异常行为检测: 在特定区域(如银行、工厂)检测打架、摔倒等异常行为。

-

辅助功能:

为残障人士提供新的交互方式,通过头部或眼球的微小运动来控制手机。

开发实践入门

如果你想在 Android 上实现动作识别,可以按照以下路径进行:

简单的传感器动作(如“摇一摇”)

- 在

AndroidManifest.xml中声明权限:<uses-permission android:name="android.permission.ACTIVITY_RECOGNITION" />

- 获取

SensorManager和传感器:val sensorManager = getSystemService(Context.SENSOR_SERVICE) as SensorManager val accelerometer = sensorManager.getDefaultSensor(Sensor.TYPE_ACCELEROMETER)

- 创建

SensorEventListener:class ShakeListener : SensorEventListener { // ... 实现接口方法 onAccuracyChanged, onSensorChanged // 在 onSensorChanged 中分析加速度数据,判断是否为“摇动” } - 注册和注销监听器:

sensorManager.registerListener(shakeListener, accelerometer, SensorManager.SENSOR_DELAY_UI) // 在 Activity/Fragment 的生命周期中注销

使用 ML Kit 进行活动识别

这是最推荐的快速上手方式。

-

添加依赖:

// build.gradle (Module level) implementation 'com.google.mlkit:activity-recognition:17.0.0'

-

创建

ActivityIdentificationClient:val client = ActivityRecognition.getClient(this)

-

请求活动识别更新:

val request = ActivityIdentificationRequest.Builder() .setIntervalDurationMillis(1000) // 识别间隔 .build() client.requestActivityUpdates(1000, pendingIntent) // pendingIntent 用于接收结果 -

在

BroadcastReceiver中处理结果: 当识别到新活动时,系统会通过pendingIntent发送一个包含ActivityIdentificationResult的广播,从中可以获取最可能的活动和置信度。

使用 MediaPipe 进行人/手姿态识别

- 添加依赖:

// build.gradle (Module level) implementation 'com.google.mediapipe:tasks-vision:latest_version' // 请使用最新版本

- 准备模型文件: 将

.task模型文件(如pose_landmarker.task)放入assets目录。 - 初始化

PoseLandmarker:val options = PoseLandmarker.PoseLandmarkerOptions.builder() .setBaseOptions(BaseOptions.builder().setModelAssetPath("pose_landmarker.task").build()) .setMinPoseDetectionConfidence(0.5f) .setMinTrackingConfidence(0.5f) .build() val poseLandmarker = PoseLandmarker.createFromFileAndOptions(this, options) - 处理相机帧:

使用

CameraX或Camera2API 捕获相机预览帧,将其转换为MPImage,然后传给poseLandmarker。val mpImage = MpImage.from(image) val result = poseLandmarker.detect(mpImage) // result 包含检测到的人体关键点列表

- 可视化结果: 使用

Canvas在TextureView或SurfaceView上绘制关键点和连接线,实现实时预览。

Android 动作识别技术已经从简单的传感器信号处理,发展到了融合传感器、计算机视觉和深度学习的复杂智能系统,对于开发者而言:

- 简单动作:优先使用

SensorManager。 - 宏观活动:直接使用 ML Kit Activity Recognition,简单高效。

- 复杂姿态/手势:强烈推荐使用 MediaPipe,功能强大且易于集成。

- 高度定制化需求:可以考虑使用 TensorFlow Lite 训练和部署自己的模型。

选择哪种技术,完全取决于你的应用场景、所需的识别精度以及开发资源。