Spark大数据处理技术是一种基于内存计算的开源分布式计算框架,由加州大学伯克利分校的AMPLab于2009年开发,并于2010年开源,它旨在解决传统大数据处理框架(如Hadoop MapReduce)在迭代计算、交互式查询和流处理等方面的性能瓶颈,通过内存计算和优化的执行引擎,显著提升了大数据处理的效率和灵活性,Spark的核心设计理念是“一次多次使用”(Write Once, Read Many),即数据一旦被加载到内存中,可以被多个计算任务重复使用,从而避免了传统MapReduce框架中每次计算都需要从磁盘读取数据的开销,特别适合需要多次迭代的机器学习算法、交互式数据分析等场景。

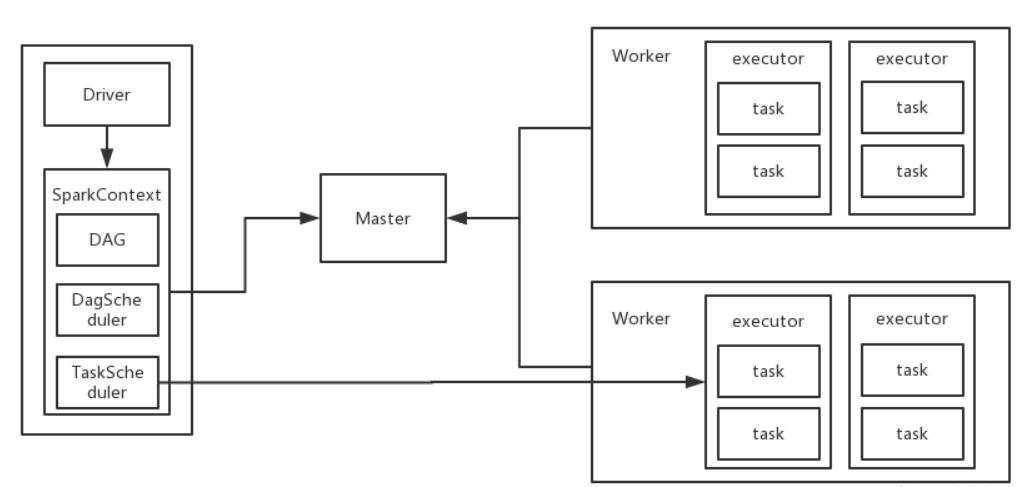

Spark生态系统由多个组件构成,形成了完整的大数据处理解决方案,核心组件包括Spark Core、Spark SQL、Spark Streaming、MLlib和GraphX,Spark Core是整个框架的基础,提供了任务调度、内存管理、 fault tolerance(容错)等核心功能,以及RDD(Resilient Distributed Dataset,弹性分布式数据集)这一核心抽象,RDD是一种不可变的、分区的分布式数据集合,支持两种操作:Transformation(转换操作,如map、filter、join等,是惰性执行的)和Action(行动操作,如count、collect、save等,会触发实际计算),这种设计使得Spark能够通过DAG(有向无环图)调度器优化计算流程,减少不必要的中间数据存储。

Spark SQL是Spark用于处理结构化数据的组件,它提供了一个名为DataFrame(或Dataset)的编程抽象,类似于关系型数据库中的表,但底层可以存储多种格式的数据(如JSON、Parquet、ORC等),Spark SQL支持SQL查询、DataFrame API以及Scala/Java/Python中的领域特定语言(DSL),使得熟悉SQL的数据分析师能够轻松上手,同时支持与Hive等数据仓库工具的集成,实现数据的无缝迁移,Spark Streaming则用于处理实时数据流,它将实时数据流分解为小的批次(batch),然后交由Spark Core的批处理引擎进行处理,从而实现准实时的流式计算,Spark Streaming支持多种数据源,如Kafka、Flume、HDFS等,并支持窗口操作(如滑动窗口、滚动窗口),适用于实时监控、实时推荐等场景。

MLlib是Spark的机器学习库,提供了常见的机器学习算法和工具,包括分类、回归、聚类、协同过滤等,以及特征提取、转换、降维等数据预处理工具,MLlib基于RDD或DataFrame构建,支持与Spark Streaming和Spark SQL的集成,能够实现端到端的机器学习流水线,GraphX是Spark的图计算库,提供了图操作和图算法的实现,如PageRank、三角形计数等,支持图的创建、转换、聚合等操作,适用于社交网络分析、推荐系统等需要图结构处理的场景。

Spark的性能优势主要体现在以下几个方面:内存计算使得Spark在迭代计算和交互式查询中性能远超传统MapReduce,例如在机器学习算法中,数据可以多次加载到内存中重复使用,避免了磁盘I/O开销;DAG调度器能够优化计算流程,通过管道化(pipelining)将多个转换操作合并为一个任务,减少中间数据的存储和传输;Spark支持多种部署模式,如本地模式、Standalone模式、YARN模式和Mesos模式,能够适应不同的集群环境;Spark支持多种编程语言,包括Scala、Java、Python和R,覆盖了不同背景的开发者需求。

Spark的应用场景非常广泛,涵盖了互联网、金融、电信、零售等多个行业,在互联网领域,Spark被用于用户行为分析、实时推荐、广告投放等场景;在金融领域,Spark被用于风险控制、欺诈检测、实时交易分析等场景;在电信领域,Spark被用于网络流量监控、用户行为分析、网络优化等场景;在零售领域,Spark被用于销售预测、库存管理、客户细分等场景,某电商平台使用Spark Streaming实时分析用户浏览和购买行为,通过机器学习算法生成个性化推荐,提升用户转化率;某银行使用Spark MLlib构建信用评分模型,实时评估贷款申请人的信用风险,降低坏账率。

Spark的部署和优化需要考虑多个因素,集群资源管理是关键,Spark可以与YARN、Mesos等集群资源管理器集成,实现资源的动态分配和调度;内存管理需要合理配置,Spark的内存分为执行内存和存储内存,需要根据应用场景调整两者的比例,避免内存溢出;数据分区和缓存策略需要优化,通过合理分区可以提高并行度,通过缓存(cache/persist)可以避免重复计算,提升性能;数据序列化方式也需要考虑,Kryo序列化比Java默认的序列化更高效,能够减少数据传输和存储的开销。

尽管Spark具有诸多优势,但在实际应用中仍面临一些挑战,Spark对内存资源要求较高,如果数据量超过内存容量,会频繁触发磁盘溢出(spill to disk),导致性能下降;Spark的容错机制依赖于RDD的血统(lineage),如果计算任务失败,需要重新执行前面的转换操作,对于复杂的计算流程,恢复时间可能较长;Spark Streaming的微批次处理模式虽然简化了流处理逻辑,但延迟通常在秒级,对于需要毫秒级延迟的场景可能不适用;Spark的调优需要一定的经验,开发者需要根据应用场景调整各种参数,如并行度、内存配置、序列化方式等,才能发挥最佳性能。

相关问答FAQs:

-

问:Spark与Hadoop MapReduce的主要区别是什么?

答:Spark与Hadoop MapReduce的主要区别在于计算模式和性能,MapReduce是一种基于磁盘的批处理框架,每次计算都需要将中间结果写入磁盘,导致I/O开销大,不适合迭代计算和交互式查询;而Spark是一种基于内存的计算框架,数据一旦加载到内存中可以被多次使用,避免了频繁的磁盘I/O,特别适合迭代计算、机器学习和交互式查询,Spark提供了更丰富的组件(如Spark SQL、Spark Streaming等),支持多种数据处理场景,而MapReduce主要用于批处理。 -

问:Spark Streaming如何实现实时数据处理?

答:Spark Streaming通过将实时数据流分解为小的批次(batch interval,如1秒、5秒等),然后交由Spark Core的批处理引擎进行处理,从而实现准实时的流式计算,每个批次的数据被转换为DStream(Discretized Stream),DStream是由一系列RDD组成的序列,对DStream的操作会转化为对RDD的操作,Spark Streaming支持多种数据源(如Kafka、Flume等),并支持窗口操作(如滑动窗口、滚动窗口),可以对时间窗口内的数据进行聚合和分析,虽然Spark Streaming的延迟通常在秒级,但其吞吐量高,适用于大多数实时数据处理场景。